hadoop伪分布模式配置

1、配置好网络,关闭iptables,关闭selinux。

配置网络参考:Linux配置静态ip访问外网

关闭防火墙:

service iptables stop

chkconfig iptables off

关闭selinux:

setenforce 0

vi /etc/selinux/config

SELINUX=disabled

2、安装好jdk并加入环境变量。

安装:

rpm -ivh jdk-7u80-linux-x64.rpm

环境变量:

vi /etc/profile

export JAVA_HOME=/usr/java/jdk1.7.0_80

export PATH=$PATH:$JAVA_HOME/bin

source /etc/profile

3、安装好hadoop并加入环境变量

安装:

tar -zxf hadoop-2.6.5.tar.gz -C /opt/apps

环境变量:

vi /etc/profile

export HADOOP_PREFIX=/opt/apps/hadoop-2.6.5

export PATH=$PATH:$HADOOP_PREFIX/bin:$HADOOP_PREFIX/sbin

source /etc/profile

#输入start双击tab键如果出现hadoop的相关脚本,则环境变量配置成功

4、配置单击版免密码登录

ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

cat ~/.ssh/id_dsa.pub > ~/.ssh/authorized_keys

#执行以上两条命令后,若执行ssh localhost不需要输入密码,则配置成功

5、配置 /opt/apps/hadoop-2.6.5/etc/hadoop/hadoop-env.sh

export JAVA_HOME=/usr/java/jdk1.7.0_80

6、配置 /opt/apps/hadoop-2.6.5/etc/hadoop/core-site.xml

<!-- namenode和其他组件的通信使用hdfs协议

Linux001表示namenode在Linux001主机上

9000 namenode的服务通过端口9000发布

namenode进程在Linux001主机上

-->

<property>

<name>fs.defaultFS</name>

<value>hdfs://Linux001:9000</value>

</property>

<!--

1、指定namenode在哪个目录存储元数据持久化文件信息

2、指定datanode在哪个目录存储block数据文件

3、指定secondarynamenode在哪个目录存储fsimage和edits log信息

实际上在该目录下分了三个目录存储上面说的三个组件的数据

该目录必须事先创建

-->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/apps/hadoop-2.6.5/tmp</value>

</property>

7、配置/opt/apps/hadoop-2.6.5/etc/hadoop/hdfs-site.xml

<!-- 指定block默认的副本数 -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<!-- 指定secondarynamenode的http服务的地址

实际上也就指定了secondarynamenode进程所在的主机

-->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>Linux001:50090</value>

</property>

8、配置/opt/apps/hadoop-2.6.5/etc/hadoop/mapred-site.xml

cp mapred-site.xml.template mapred-site.xml

vi mapred-site.xml

<!--配置mapreduce运行的平台-->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

9、配置/opt/apps/hadoop-2.6.5/etc/hadoop/yarn-site.xml

vi yarn-site.xml

<!--配置yarn的主节点-->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>Linux001</value>

</property>

<!--配置MapReduce处理数据的方式-->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

10、配置 /opt/apps/hadoop-2.6.5/etc/hadoop/slaves

<!--配置DataNode节点的地址-->

Linux001

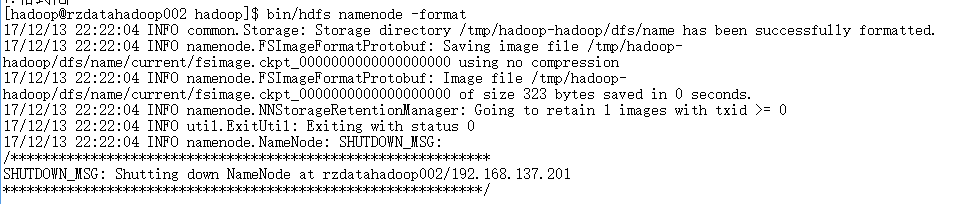

11、格式化HDFS

/opt/apps/hadoop-2.6.5/bin/hdfs namenode -format

注意

修改了core-site.xml文件必须重新格式化

格式化成功:

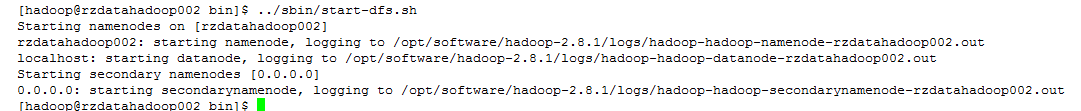

11、启动HDFS

. start-dfs.sh

#已经配好了hadoop的环境变量,在任意路径都可以执行这条命令

启动成功后可用ip:50070在浏览器上访问hdfs的web界面

额外的工作

问题:

观察启动hdfs打印的日志发现启动namenodes、datanode、secondary namenodes的机器不一样,如何修改成一样的。

解决:

1、关闭所有hadoop相关进程:kill -9 $(pgrep -f hadoop)。

2、针对secondary namenode的修改:

vi hdfs-site.xml

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>Linux001:50090</value>

</property>

<property>

<name>dfs.namenode.secondary.https-address</name>

<value>Linux001:50091</value>

</property>

3、针对datanode的修改:

vi slaves

Linux001

4、针对namenode的修改

vi core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hdfs://Linux001:9000</value>

</property>