spark官方网站 http://spark.apache.org/

点击 downLoad

分别对应的是spark版本,还有 Hadoop的版本,要考虑一下兼容性的问题

在Hadoop 2.7 那一行 有 Source Code 可以下载 spark对应的源码包

1. Spark的特点

速度很快:

与 Hadoop 的 MapReduce 相比,Spark 基于内存的运算要快 100 倍以上,基

于硬盘的运算也要快 10 倍以上。Spark 实现了高效的 DAG 执行引擎,可以通过

基于内存来高效处理数据流。

易用:

Spark 支持 Java、Python 和 Scala 的 API,还支持超过 80 种高级算法,使用户可以快速构建不同的应用。而且 Spark 支持交互式的 Python 和 Scala 的 shell,可以非常方便地在这些 shell 中使用 Spark 集群来验证解决问题的方法。

Spark 提供了统一的解决方案。Spark 可以用于批处理、交互式查询

(Spark SQL)、实时流处理(Spark Streaming)、机器学习(Spark MLlib)和图计算(GraphX)。这些不同类型的处理都可以在同一个应用中无缝使用。Spark

统一的解决方案非常具有吸引力,毕竟任何公司都想用统一的平台去处理遇到的

问题,减少开发和维护的人力成本和部署平台的物力成本。

兼容性强:

Spark 可以非常方便地与其他的开源产品进行融合。比如,Spark 可以使用

Hadoop 的 YARN 和 Apache Mesos 作为它的资源管理和调度器,器,并且可以处理所有 Hadoop 支持的数据,包括 HDFS、HBase 和 Cassandra 等。这对于已经部署 Hadoop 集群的用户特别重要,因为不需要做任何数据迁移就可以使用

Spark的强大处理能力。Spark 也可以不依赖于第三方的资源管理和调度器,它实现了Standalone 作为其内置的资源管理和调度框架,这样进一步降低了 Spark 的使用门槛,使得所有人都可以非常容易地部署和使用 Spark。此外,Spark 还提供了在EC2 上部署 Standalone 的 Spark 集群的工具。

安装spark

首先需要有hadoop的环境.ok,接下来我们言归正传,开始干活.

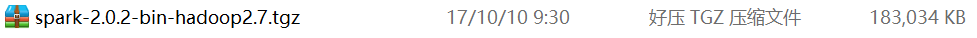

这里我用的是 2.0.2 和 2.7

找到你的压缩包位置.传入Linux

第二步:开始解压

tar -zxvf spark-2.0.2-bin-hadoop2.7.tgz -C (加你的路径) 推荐是绝对路径,相对路径有点晕吧…

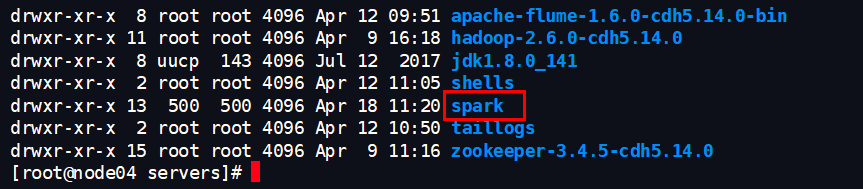

我改了名字

mv spark-2.0.2-bin-hadoop2.7 spark 就可以吧名字给改了

接下来我们来修改配置文件吧

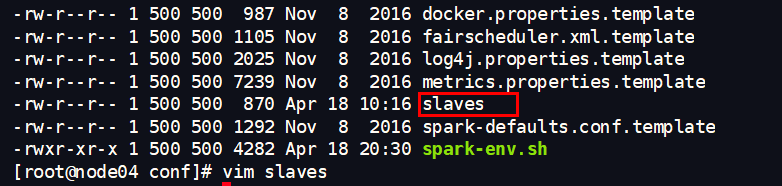

cd /export/servers/spark/conf

mv spark-env.sh.template spark-env.sh (我还是改了文件名,别晕了啊)

ok,接下来修改我们的配置文件

vim spark-env.sh

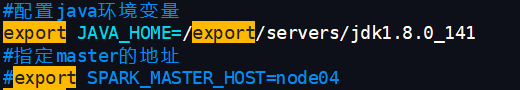

export JAVA_HOME=/export/servers/jdk1.8.0_141

#指定 spark 老大 Master 的 IP

export SPARK_MASTER_HOST=node04

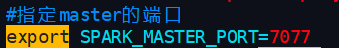

#指定 spark 老大 Master 的端口

export SPARK_MASTER_PORT=7077

这个后面会注释掉master 因为配置高可用,现在是配置单机的 这个东西是要指定的,

图片是有一丢丢问题(懒惰一下…)

修改 slave

vim slave

,这个我的节点名字,你们不同注意换

把spark发到你别的机器上面

scp -r /export/servers/spark node05:/export/servers (推荐绝对路径)

这个也没有问题,效果一样的 … 有几台发几台 注意 node0X的名字啊,别忘记改了傻乎乎的,哈哈

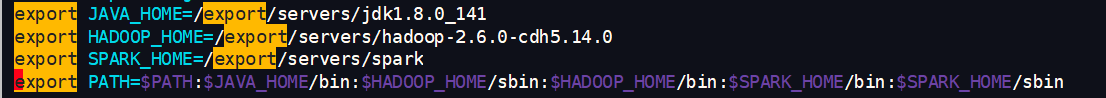

配置spark的环境变量

将 spark 添加到环境变量,添加以下内容到 vim /etc/profile

export JAVA_HOME=/export/servers/jdk1.8.0_141

export HADOOP_HOME=/export/servers/hadoop-2.6.0-cdh5.14.0

export SPARK_HOME=/export/servers/spark

export PATH=PATH:JAVA_HOME/bin:HADOOPHOME/sbin:HADOOP_HOME/bin:SPARKHOME/bin:SPARK_HOME/sbin

注意最后 source /etc/profile 刷新配置

启动spark

cd /export/servers/spark/sbin 这个目录下面启动

到了sbin

./start-all.sh

这样就启动了

jps查看进程 其他两台是 Worker

谷歌上面看到这个界面就算完成

停止spark集群

/export/servers/spark/sbin/stop-all.sh