raw string是不包含对转义符再次转义的字符串

re库也可以采用string类型表示正则表达式,但更繁琐

例如:

‘[1‐9]\\d{5}’

‘\\d{3}‐\\d{8}|\\d{4}‐\\d{7}’

建议:当正则表达式包含转义符时,使用raw string

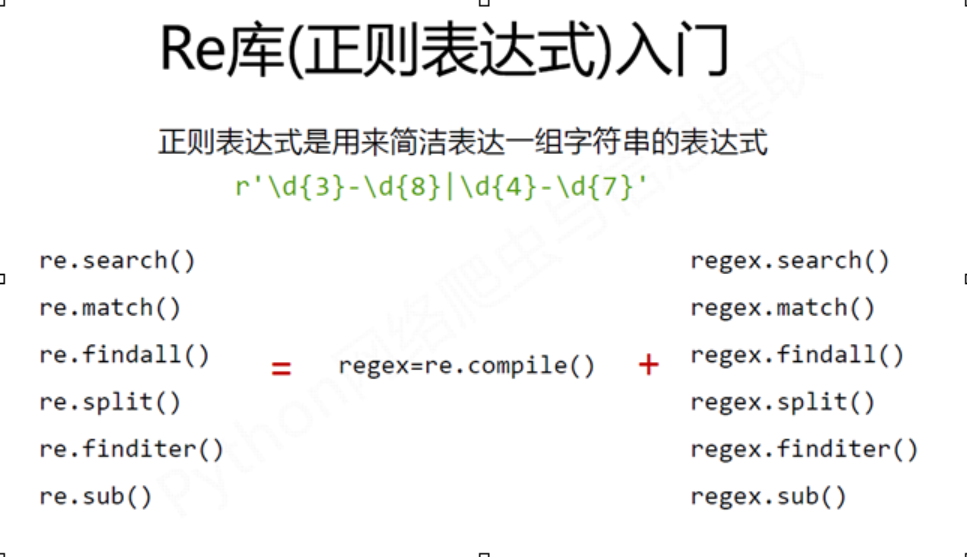

re库主要功能函数

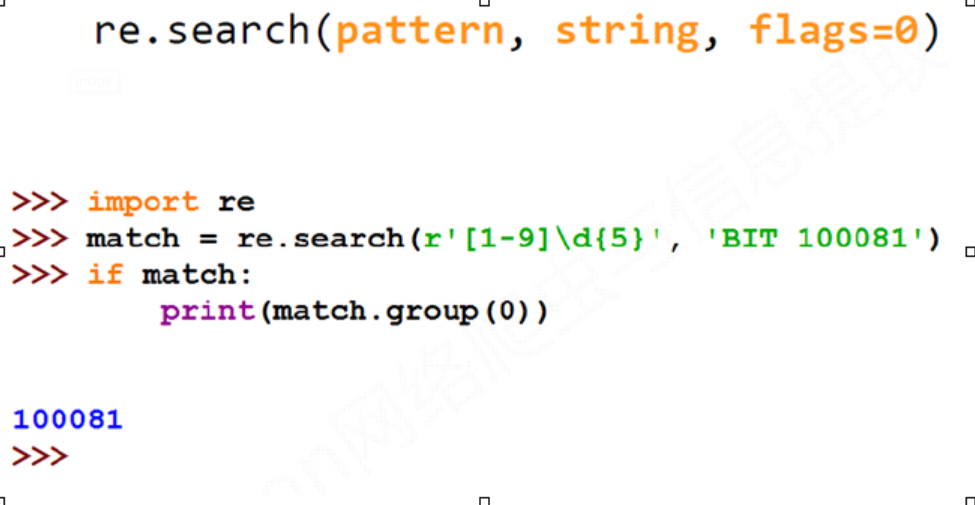

re.search() 在一个字符串中搜索匹配正则表达式的第一个位置,返回match对象

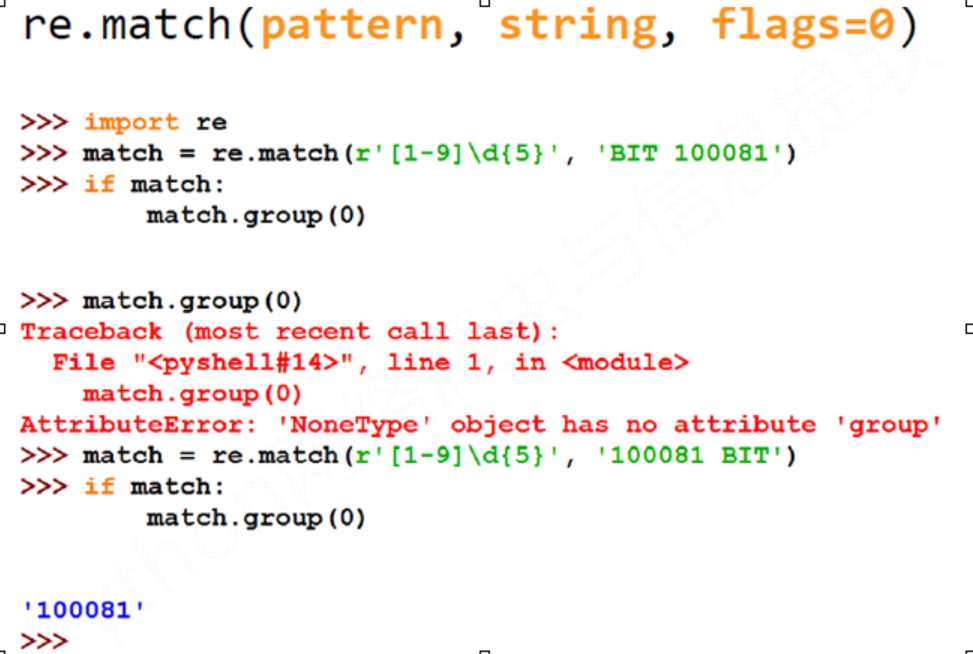

re.match() 从一个字符串的开始位置起匹配正则表达式,返回match对象

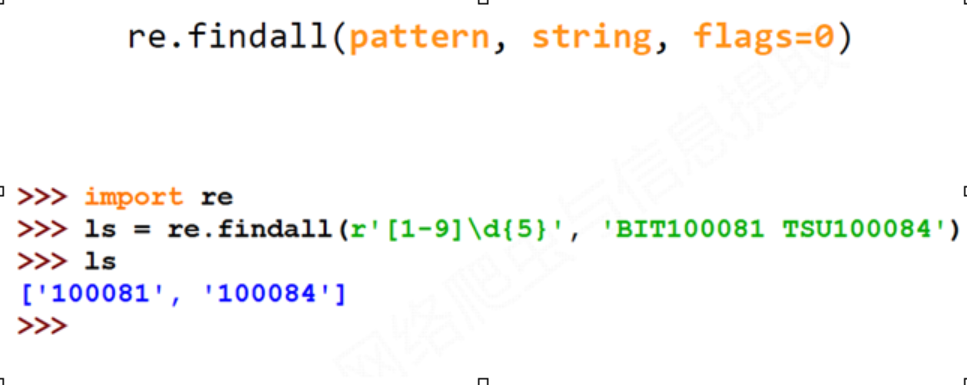

re.findall() 搜索字符串,以列表类型返回全部能匹配的子串

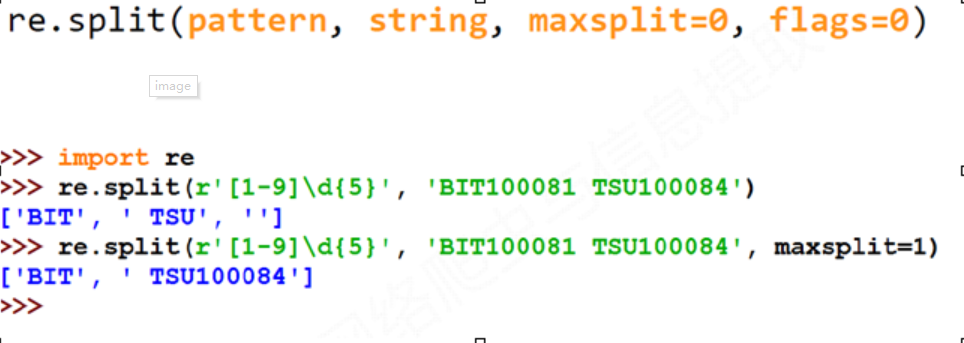

re.split() 将一个字符串按照正则表达式匹配结果进行分割,返回列表类型

re.finditer() 搜索字符串,返回一个匹配结果的迭代类型,每个迭代元素是match对象

re.sub() 在一个字符串中替换所有匹配正则表达式的子串,返回替换后的字符串

re.search(pattern, string, flags=0)

? pattern : 正则表达式的字符串或原生字符串表示

? string : 待匹配字符串

? flags : 正则表达式使用时的控制标记

常用标记

re.I re.IGNORECASE 忽略正则表达式的大小写,[A‐Z]能够匹配小写字符

re.M re.MULTILINE 正则表达式中的^操作符能够将给定字符串的每行当作匹配开始

re.S re.DOTALL 正则表达式中的.操作符能够匹配所有字符,默认匹配除换行外的所有字符

re.match(pattern, string, flags=0)

. pattern : 正则表达式的字符串或原生字符串表示

. string : 待匹配字符串

. flags : 正则表达式使用时的控制标记

re.findall(pattern, string, flags=0)

. pattern : 正则表达式的字符串或原生字符串表示

. string : 待匹配字符串

. flags : 正则表达式使用时的控制标记

re.split(pattern, string, maxsplit=0, flags=0)

. pattern : 正则表达式的字符串或原生字符串表示

. string : 待匹配字符串

. maxsplit: 最大分割数,剩余部分作为最后一个元素输出

. flags : 正则表达式使用时的控制标记

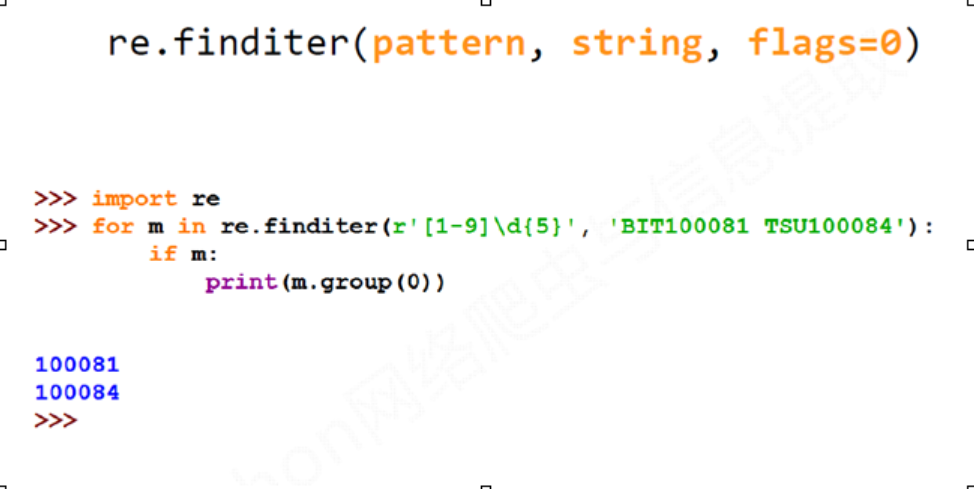

re.finditer(pattern, string, flags=0)

? pattern : 正则表达式的字符串或原生字符串表示

? string : 待匹配字符串

? flags : 正则表达式使用时的控制标记

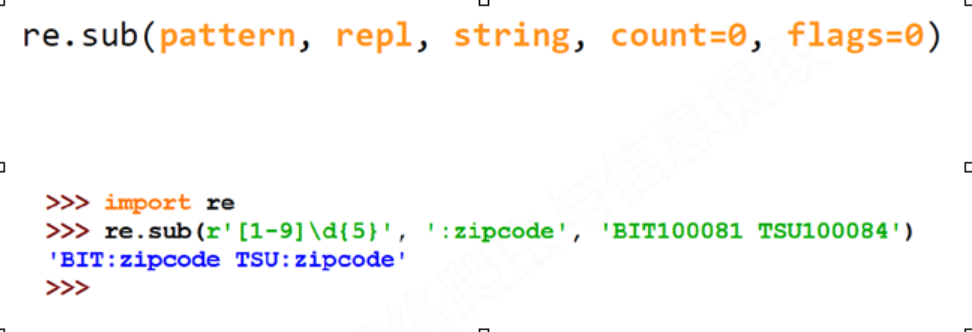

re.sub(pattern, repl, string, count=0, flags=0)

? pattern : 正则表达式的字符串或原生字符串表示

? repl : 替换匹配字符串的字符串

? string : 待匹配字符串

? count : 匹配的最大替换次数

? flags : 正则表达式使用时的控制标记

regex = re.compile(pattern, flags=0)

? pattern : 正则表达式的字符串或原生字符串表示

? flags : 正则表达式使用时的控制标记

>>> regex = re.compile(r'[1‐9]\d{5}’)

regex.search() 在一个字符串中搜索匹配正则表达式的第一个位置,返回match对象

regex.match() 从一个字符串的开始位置起匹配正则表达式,返回match对象

regex.findall() 搜索字符串,以列表类型返回全部能匹配的子串

regex.split() 将一个字符串按照正则表达式匹配结果进行分割,返回列表类型

regex.finditer() 搜索字符串,返回一个匹配结果的迭代类型,每个迭代元素是match对象

regex.sub() 在一个字符串中替换所有匹配正则表达式的子串,返回替换后的字符串

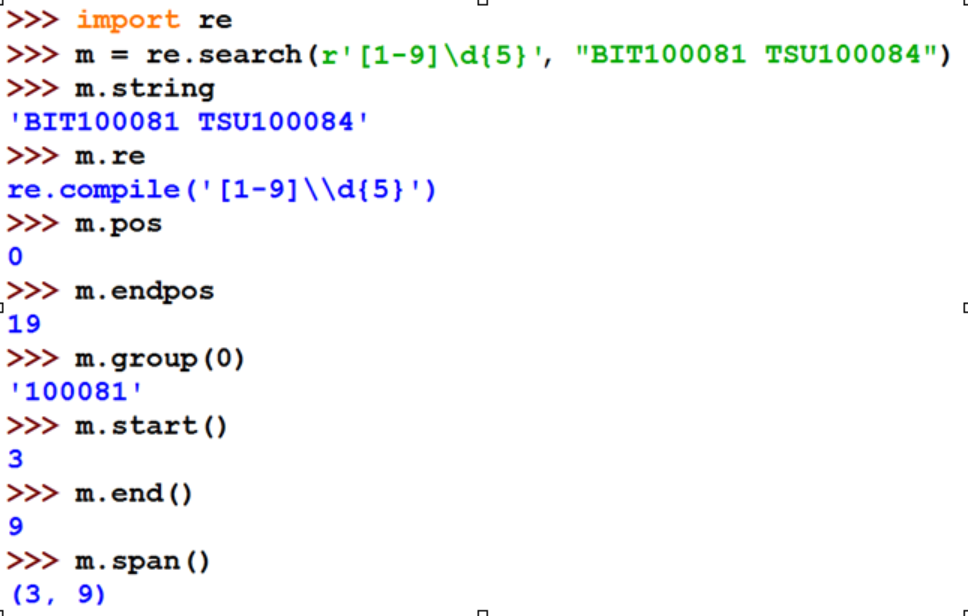

Match对象是一次匹配的结果,包含匹配的很多信息

Match对象的属性:

.string 待匹配的文本

.re 匹配时使用的patter对象(正则表达式)

.pos 正则表达式搜索文本的开始位置

.endpos 正则表达式搜索文本的结束位置

Match对象的方法:

.group(0) 获得匹配后的字符串

.start() 匹配字符串在原始字符串的开始位置

.end() 匹配字符串在原始字符串的结束位置

.span() 返回(.start(), .end())

Re库的贪婪和最小匹配

Re库默认采用贪婪匹配,即输出匹配最长的子串

最小匹配操作符:

*? 前一个字符0次或无限次扩展,最小匹配

+? 前一个字符1次或无限次扩展,最小匹配

?? 前一个字符0次或1次扩展,最小匹配

{m,n}? 扩展前一个字符m至n次(含n),最小匹配

只要长度输出可能不同的,都可以通过在操作符后增加?变成最小匹配

4.2 淘宝商品比价定向爬虫

import requests

import re

def getHTMLText(url):

try:

r = requests.get(url, timeout=30)

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

return ""

def parsePage(ilt, html):

try:

plt = re.findall(r'\"view_price\"\:\"[\d\.]*\"',html)

tlt = re.findall(r'\"raw_title\"\:\".*?\"',html)

for i in range(len(plt)):

price = eva l(plt[i].split(':')[1])

title = eva l(tlt[i].split(':')[1])

ilt.append([price , title])

except:

print("")

def printGoodsList(ilt):

tplt = "{:4}\t{:8}\t{:16}"

print(tplt.format("序号", "价格", "商品名称"))

count = 0

for g in ilt:

count = count + 1

print(tplt.format(count, g[0], g[1]))

def main():

goods = '书包'

depth = 3

start_url = 'https://s.taobao.com/search?q=' + goods

infoList = []

for i in range(depth):

try:

url = start_url + '&s=' + str(44*i)

html = getHTMLText(url)

parsePage(infoList, html)

except:

continue

printGoodsList(infoList)

main()

4.3 股票数据定向爬虫

import requests

from bs4 import BeautifulSoup

import traceback

import re

def getHTMLText(url, code="utf-8"):

try:

r = request