|

reduce.framework.name</name>

27 <value>yarn</value>

28 </property>

29 <!-- 第五个:yarn-site.xml-> 30 <!-- 指定YARN的老大(ResourceManager)的地址 -->

31 <property>

32 <name>yarn.resourcemanager.hostname</name>

33 <value>hadoop01</value>

34 </property>

35 <!-- reducer获取数据的方式 -->

36 <property>

37 <name>yarn.nodemanager.aux-services</name>

38 <value>mapreduce_shuffle</value>

39 </property>

将hadoop添加到环境变量

1 vim /etc/proflie 2 export JAVA_HOME=/usr/local/jdk1.7.0_80 3 export HADOOP_HOME=/bigdata/hadoop-2.6.4

4 export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin

刷新配置文件

格式化namenode(是对namenode进行初始化) 格式化文件系统

hdfs namenode -format(历史命令 hadoop namenode -format)

启动hadoop

先启动HDFS

sbin/start-dfs.sh

再启动YARN

sbin/start-yarn.sh

验证是否启动成功

使用jps命令验证

27408 NameNode

28218 Jps

27643 SecondaryNameNode

28066 NodeManager

27803 ResourceManager

27512 DataNode

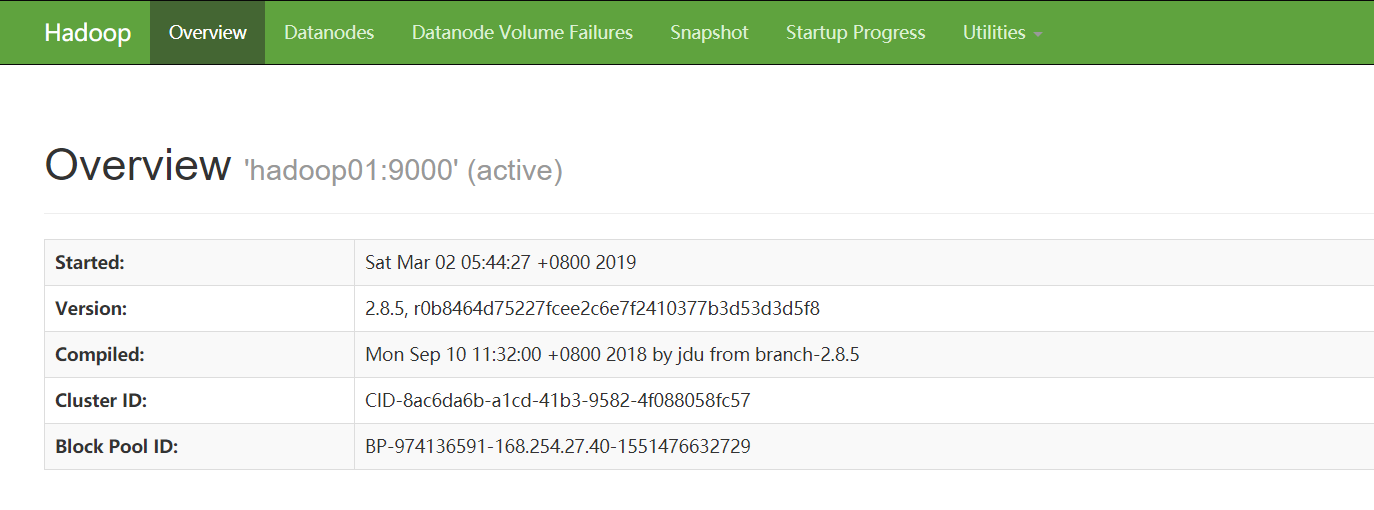

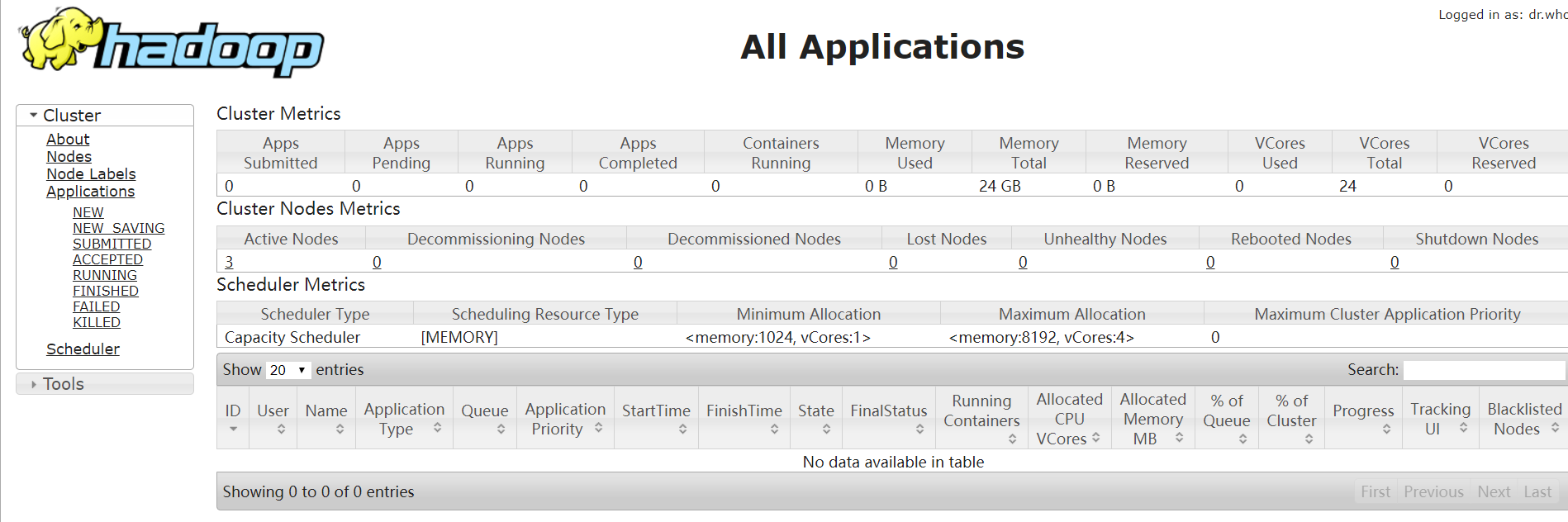

通过网页验证

http://192.168.35.100:50070 (HDFS管理界面)

http://192.168.35.100:8088 (MR管理界面)

3、配置ssh免登陆

#生成ssh免登陆密钥

#进入到我的home目录

cd ~/.ssh

ssh-keygen -t rsa (四个回车)

执行完这个命令后,会生成两个文件id_rsa(私钥)、id_rsa.pub(公钥)

将公钥拷贝到要免密登陆的目标机器上

ssh-copy-id localhost

到此HDFS和MapReduce搭建完成,有任何出错或疑问可以私信留言也可以关注微信公众号;关于Hadoop的后续还会陆续给大家一一讲解,谢谢阅读。

|